جدول المحتويات

ما هو ملف الروبوت تكست Robots.txt وأهميته في تحسين محركات البحث

جدول المحتويات

ما هو ملف Robots.txt

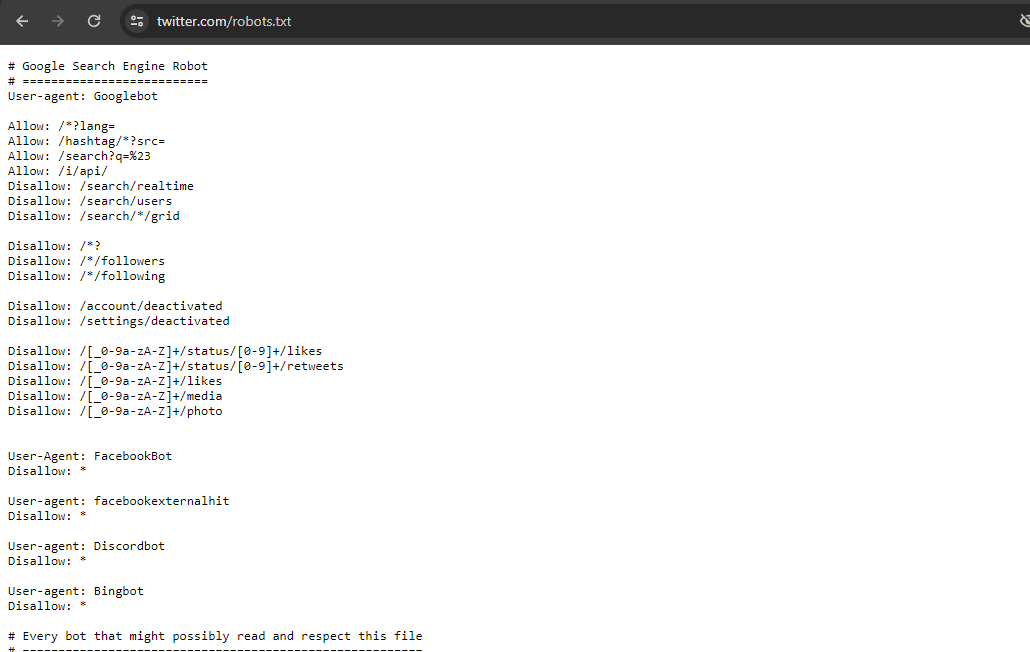

ملف robots.txt هو دليل لروبوتات الويب، والذي تستخدمه عادةً محركات البحث، لتحديد أجزاء الموقع التي يمكن الزحف إليها وفهرستها يعد هذا الملف حجر الزاوية في بروتوكول استبعاد الروبوتات (REP) وهو عبارة عن مجموعة من معايير الويب المصممة للتحكم في كيفية تفاعل الروبوتات مع محتوى الويب لا يشمل REP ملف robots.txt فقط، بل يتضمن أيضًا علامات وتوجيهات meta robots التي تدير كيفية تعامل روبوتات محركات البحث مع الروابط مثل “follow” أو “nofollow”.

تتمثل الوظيفة الأساسية لملف روبوت تكست في إدارة وتوجيه سلوك الزحف لروبوتات الويب من خلال تحديد ما هو محظور باستخدام أوامر “عدم السماح” أو “السماح”، يمكن لمشرفي المواقع التحكم في مستوى وصول وكلاء المستخدم المختلفين (المصطلح الفني لبرنامج الزحف على الويب) إلى أقسام مختلفة من موقع الويب الخاص بهم. يساعد هذا الإذن الانتقائي في تحسين تفاعل الموقع مع محركات البحث، مما يضمن أن الأجزاء المقصودة فقط هي التي يتم الزحف إليها وفهرستها، مما يساعد بدوره في التحكم في ظهور الموقع على الويب.

يعمل ملف Robots.txt بمثابة خريطة طريق لمحركات البحث، حيث يحدد أجزاء موقع الويب التي يجب استكشافها وتلك التي يجب أن تظل دون تغيير وهو أمر بالغ الأهمية لتوجيه برامج زحف محركات البحث، ولكنه ليس أداة لإخفاء الصفحات من فهرس Google.

فيما يلي لقطة لما قد يتضمنه ملف Robots.txt:

على الرغم من أن ملفات Robots.txt تبدو معقدة، إلا أنها مدعومة بتركيبة بسيطة سنتعرف عليها في هذا المقال والذي يتضمن

- أهمية ملفات Robots.txt

- كيف تعمل ملفات Robots.txt

- خطوات إنشاء ملف Robots.txt

- أفضل الممارسات لملف Robots.txt

بعد التعرف على أساسيات ملفات robots.txt، هل أنت مستعد لتحسين تفاعل موقعك مع محركات البحث؟ اتصل بنا الآن للتأكد من تكوين ملف robots.txt الخاص بموقعك بشكل صحيح لتحسين ظهورك على الإنترنت.

أهمية ملف Robots.txt

تلعب ملفات Robots.txt دورًا محوريًا في توجيه حركة مرور برامج زحف الويب للتأكد من أنها لا تسبب ضغط على موارد موقعك أو الصفحات التي تهدف إلى الحفاظ على خصوصيتها وعدم أرشفتها هذه الاسباب التى توضح أهمية استخدام ملف الروبوت تكست.

تعظيم ميزانية الزحف

ميزانية الزحف هي حصة الصفحات التي يخصصها محرك البحث للزحف إلى موقعك خلال فترة معينة تختلف هذه الحصة بناءً على حجم موقعك وصحته وعدد الروابط التي تؤدي اليه إذا تجاوز حجم صفحات موقعك ميزانية الزحف، فقد تظل بعض الصفحات غير مفهرسة ولن تظهر هذه الصفحات في نتائج البحث، مما يجعل الجهد المبذول فيها عديم الجدوى.

يتيح استخدام ملف Robots.txt لاستبعاد الصفحات غير الأساسية لبرامج زحف محركات البحث مثل Googlebot التركيز على المحتوى المهم.

تجدر الإشارة إلى أن ميزانية الزحف عادة ما تكون مصدر قلق لمواقع الويب الموسعة التي تحتوي على عدد لا يحصى من عناوين URL.

حجب الصفحات المكررة والخاصة وتحسين الفهرسة

باستثناء الصفحات العامة ليست كل صفحة مخصصة للظهور في نتائج محركات البحث لا تحتاج برامج الزحف إلى أرشفة الصفحات مثل بيئات الاختبار أو صفحات نتائج البحث الداخلية أو التكرارات أو صفحات تسجيل الدخول.

تعمل بعض أنظمة إدارة المحتوى (CMS)، مثل WordPress، على تقييد الوصول تلقائيًا إلى صفحات معينة، مثل صفحة تسجيل الدخول /wp-admin/، من جميع برامج الزحف ويوفر لك ملف Robots.txt الوسائل اللازمة لإبعاد هذه الصفحات عن محركات البحث.

إخفاء الموارد

في بعض الأحيان قد ترغب في الاحتفاظ بموارد معينة مثل ملفات PDF ومقاطع الفيديو والصور خارج نتائج البحث، إما للحفاظ على خصوصيتها أو لتوجيه انتباه Google نحو محتوى أكثر أهمية تضمن ملفات Robots.txt عدم الزحف إلى هذه الموارد وبالتالي عدم فهرستها.

لماذا تحتاج لملف روبوت تكست

يعد ملف robots.txt أمرًا بالغ الأهمية لتوجيه سلوك محركات البحث على موقعك كما أن موضعه لا يقل أهمية عن فعاليته ويجب أن يكون موجودًا في الدليل الرئيسي أو المجال الجذر لموقعك حتى تتمكن محركات البحث وروبوتات الزحف على الويب من العثور عليه. وهذا يعني أنه إذا كان عنوان URL لموقع الويب الخاص بك هو www.example.com، فمن المفترض أن يكون ملف robots.txt الخاص بك متاحًا على www.example.com/robots.txt.

سبب أهمية الموضع الصحيح لملف روبوت تكست

تبحث محركات البحث والروبوتات عن ملف robots.txt على مستوى المجال الجذر إذا تم وضعه في دليل فرعي، فلن يتم العثور عليه، وسيتم التعامل مع الموقع كما لو أنه لا يحتوي على ملف robots.txt يضمن الموضع الصحيح أن جميع التوجيهات الموجودة في الملف قد تم الإقرار بها واتباعها من قبل وكلاء المستخدم، مما يسمح لك بالتحكم في أجزاء موقعك التي يتم الزحف إليها وفهرستها.

كيف تعمل ملفات Robots.txt

تقوم ملفات Robots.txt بتوجيه روبوتات محركات البحث إلى عناوين URL المسموح لها بالزحف إليها وعناوين URL التي يجب عليها تجاوزها.

تهدف محركات البحث في المقام الأول إلى:

- الزحف إلى الويب لاكتشاف المحتوى

- فهرسة المحتوى وتقديمه للمستخدمين الباحثين عن المعلومات

- أثناء اجتياز الروبوتات للويب، فإنها تتبع الروابط عبر شبكة موسعة من الروابط والصفحات والمواقع.

عند مواجهة ملف Robots.txt، ترجع الروبوتات إليه أولاً لفهم حدودها على موقعك.

لغة Robots.txt واضحة ومباشرة، وتتضمن تحديد وكيل المستخدم (الروبوت المعني) وتطبيق التوجيهات (التعليمات).

يتيح لك استخدام حرف البدل الخاص بالعلامة النجمية (*) تعميم التوجيهات عبر جميع برامج الروبوت، وتوحيد القواعد لجميع برامج الزحف.

على سبيل المثال، تسمح القاعدة التالية لجميع الروبوتات، باستثناء DuckDuckGo، بفحص موقعك:

User-agent: *

Allow: /

User-agent: DuckDuckGo

Disallow: /

ضع في اعتبارك أن ملفات Robots.txt تقترح الإرشادات بدلاً من فرضها فهي تشبه مدونة سلوكية حيث تلتزم الروبوتات ذات السمعة الطيبة بها، في حين أن الروبوتات الضارة قد لا تلتزم بها.

طريقة تحديد موقع ملف Robots.txt الخاص بموقعك

يوجد ملف robots.txt الخاص بكل موقع على مستوى الخادم، ويعمل كمنارة لبرامج زحف محركات البحث للتحقق من ملف robots.txt الخاص بموقع ما، ما عليك سوى إلحاق “/robots.txt” بعنوان URL الأساسي للصفحة الرئيسيةعلى سبيل المثال:

https://yoursite.com/robots.txt

من الضروري وضع ملف robots.txt في النطاق الجذر (على سبيل المثال، www.example.com/robots.txt) لضمان التعرف عليه بواسطة برامج الزحف. قد يؤدي وضعه في مكان آخر إلى الاعتقاد بأن موقعك لا يحتوى على ملف روبوت تكست.

فهم بناء جمل ملف روبوت تكست Robots.txt

تتضمن بنية ملف robots.txt ما يلي:

كتل التوجيهات، كل منها مصمم خصيصًا لـ “وكيل مستخدم” محدد (أو روبوت محرك البحث)،

مصحوبة بأوامر “السماح” أو “عدم السماح” للتحكم في الوصول.

قد يبدو التوجيه الأساسي كما يلي:

User-agent: Googlebot

Disallow: /not-for-google

User-agent: DuckDuckBot

Disallow: /not-for-duckduckgo

Sitemap: https://www.yourwebsite.com/sitemap.xml

توجيه وكيل المستخدم

يحدد هذا السطر الزاحف الذي تنطبق عليه التعليمات. على سبيل المثال، لاستبعاد Googlebot من منطقة إدارة WordPress الخاصة بموقعك:

User-agent: Googlebot

Disallow: /wp-admin/

تذكر أن محركات البحث تنشر روبوتات مختلفة لمهام فهرسة مختلفة (مثل الويب العام والصور ومقاطع الفيديو).

عند مواجهة توجيهات متعددة، تختار الروبوتات المجموعة الأكثر قابلية للتطبيق. على سبيل المثال، سيستهدف التوجيه الخاص بـ Googlebot-Image هذا الروبوت على وجه التحديد.

توجيه عدم السماح

يحدد هذا التوجيه أقسام الموقع التي يجب على الروبوتات تخطيها. يعني سطر “عدم السماح” الفارغ أنه تم منح الوصول الكامل وعلى العكس من ذلك، لمنع وصول جميع الروبوتات:

User-agent: *

Disallow: /

على الرغم من أن التوجيهات مثل “Allow” و”Disallow” ليست حساسة لحالة الأحرف، إلا أن المسارات التي تشير إليها هي حساسة لحالة الاحرف.

توجيه السماح

يسمح لمحركات البحث بالزحف إلى مناطق محددة داخل الأقسام المحظورة. والجدير بالذكر أن هذا الأمر يتم الاعتراف به من قبل محركات البحث مثل Google وBing.

مثال إذا كنت تريد لجوجل بوت عدم أرشفة المدونة والسماح بأرشفة مقالة واحدة فسيكون التوجيه داخل ملف روبوت تكست كالتالي:

# منع Googlebot من الزحف لجميع صفحات المدونة

User-agent: Googlebot

Disallow: /blog/

# السماح لـ Googlebot بالزحف إلى مشاركة واحدة في المدونة

User-agent: Googlebot

Allow: /blog/my-post/

توجيه خريطة الموقع

إالإشارة إلى خريطة موقعك Sitemap.xml لمحركات البحث (خاصة Bing وYandex وGoogle) تساعد في الفهرسة يمكن وضع رابط خريطة موقعك في أي مكان في ملف robots.txt الخاص بك وسوف يبدو ملف روبوت تكست في هذه الحالة بالشكل التالي:

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

User-agent: Yandexbot

Allow: /

https://yoursite.com/sitemap.xml

على الرغم من أن إضافة توجيه ملف Sitemap مفيد، إلا أنه يوصى بإرسال ملف Sitemap مباشرةً عبر أدوات مشرفي المواقع من أجل فهرسة أسرع.

توجيه تأخير الزحف

يؤدي توجيه تأخير الزحف إلى تعيين فترة انتظار بين عمليات الزحف لمنع التحميل الزائد على الخادم. والجدير بالذكر أن جوجل لا تتعرف على هذا التوجيه، لكن Bing وYandex يتعرفان عليه.

توجيه Noindex

لا يمكن لملف robots.txt توجيه محركات البحث بشأن ما لا يجب فهرسته للحصول على استبعاد آمن من نتائج البحث، استخدم علامة meta robots مع توجيه noindex بدلاً من ذلك.

طريقة إنشاء ملف Robots.txt

لإنشاء ملف روبوت تكست إما أن تستخدم أداة إنشاء أو أنشئ ملف .txt يدويًا، وتجنب معالجات النصوص لمنع حدوث مشكلات في التنسيق. قم بتسمية ملفك “robots.txt”.

إضافة التوجيهات

يجب أن يحتوي ملفك على مجموعات من التوجيهات التي تحدد أذونات الوصول لوكلاء المستخدم المختلفين والمسارات المسموح بها أو غير المسموح بها وضمن عنوان URL لخريطة موقعك (اختياريًا).

مثال للتوجيهات (القواعد):

User-agent: Googlebot

Disallow: /clients/

Disallow: /not-for-google

بعد تفصيل توجيهات محددة، يمكنك تحديد تعليمات أوسع باستخدام حرف البدل “*” لجميع الروبوتات، باستثناءها من أدلة معينة للاستخدام الداخلي:

User-agent: *

Disallow: /archive/

Disallow: /support/

وأخيرًا، قم باضافة خريطة موقعك وهذا أمر اختياري.

خريطة الموقع: https://www.yourwebsite.com/sitemap.xml

تأكد من حفظ ملف robots.txt بشكل صحيح باسم “robots.txt” وتنظيمه باستخدام وكلاء مستخدم محددين في البداية، متبوعًا بتعليمات أكثر عمومية. وهذا يساعد برامج الزحف على تفسير توجيهاتك بدقة

رفع ملف روبوت تكست Robots.txt على موقعك

بمجرد إنشاء ملف robots.txt وحفظه على جهاز الكمبيوتر الخاص بك، فإن الخطوة التالية هي تحميله على موقعك مما يجعله قابلاً للاكتشاف من محركات البحث. يمكن أن تختلف هذه العملية بناءً على بنية موقعك والنظام الذي يستضيفه، حيث لا توجد طريقة واحدة تناسب الجميع لتحميل الملفات.

للحصول على تعليمات محددة مصممة خصيصًا لمنصة موقعك ابحث عبر الإنترنت أو استشر موارد الدعم الخاصة بموفر الاستضافة. على سبيل المثال، قد تبحث عن “كيفية تحميل ملف robots.txt إلى WordPress” للحصول على إرشادات خاصة بـ WordPress.

فيما يلي أدلة لتحميل ملف robots.txt الخاص بك على الأنظمة الأساسية الشائعة:

بعد التحميل، تأكد من إمكانية الوصول إلى ملف robots.txt لكل من المستخدمين ومحركات البحث عن طريق التحقق من عنوان URL الخاص به مباشرةً، مثل https://yoursite.com/robots.txt.

اختبار ملف Robots.txt الخاص بك

للتحقق من إعداد ملف robots.txt بشكل صحيح وإمكانية الوصول إليه، قم بتنفيذ الخطوات التالية:

تحقق من إمكانية الوصول العامة

افتح نافذة التصفح المتخفي في متصفحك وانتقل إلى عنوان URL لملف robots.txt (على سبيل المثال، https://yoursite.com/robots.txt). إذا كان بإمكانك عرض المحتويات التي حددتها، فهذا يعني أنه تم تحميل ملفك بشكل صحيح.

استخدم أدوات اختبار جوجل

توفر Google أدوات لتقييم ملف robots.txt الخاص بك، بما في ذلك أداة اختبار ملف robots.txt في Google Search Console. تساعد هذه الأداة في تحديد مشكلات بناء الجمل أو الأخطاء المنطقية. ومع ذلك، لاحظ أن استخدام هذه الأداة يتطلب حساب Search Console مرتبطًا بموقعك على الويب.

التدقيق باستخدام أدوات الطرف الثالث

يمكن لأدوات مثل Semrush Site Audit أيضًا فحص ملف robots.txt الخاص بك بحثًا عن الأخطاء، وتقديم رؤى حول المشكلات المحتملة وكيفية حلها.

أفضل الممارسات الخاصة بملف Robots.txt

لضمان الأداء الأمثل لملف robots.txt، التزم بأفضل الممارسات التالية:

تنسيق التوجيهات بشكل صحيح

يجب أن يكون كل توجيه في سطر خاص به لسهولة القراءة بواسطة محركات البحث. يمكن أن تؤدي التوجيهات المنسقة بشكل غير صحيح إلى سوء الفهم والتفسير من برامج وبوتات الزحف.

مثال غير صحيح

User-agent: Googlebot

Disallow: /admin/Disallow: /login/

Allow: /blog/

مثال صحيح لتنسيق توجيهات ملف Robots.txt

User-agent: Googlebot

Disallow: /admin/

Disallow: /login/

Allow: /blog/

الاستخدام المفرد لوكيل المستخدم

قد يؤدي تكرار نفس وكيل المستخدم عدة مرات إلى حدوث ارتباك لذلك قم بتوحيد التوجيهات تحت إدخال وكيل مستخدم واحد من أجل الوضوح.

مثال لتعليمات مكررة ومربكه:

User-agent: Googlebot

Disallow: /admin/

User-agent: Googlebot

Disallow: /login/

User-agent: Bingbot

Disallow:

مثال تعليمات واضحة:

User-agent: Googlebot

Disallow: /admin/

User-agent: Googlebot

Disallow: /login/

User-agent: Bingbot

Disallow: /

الاستفادة من أحرف البدل

استخدم أحرف البدل (*) لتطبيق القواعد على نطاق واسع أو لمطابقة أنماط عناوين URL بكفاءة، وتجنب الحاجة إلى إدراج عناوين URL الفردية على سبيل المثال يمكن استخدام حرف البدل (*) لمنع عناوين URL التي تحتوى على معلمات محددة بدلا من ادخالها واحدة تلو الاخرى مثال:

User-agent: Googlebot

Disallow: /images/*

حدد نهايات URL

استخدم الرمز “$” للإشارة إلى نهاية عنوان URL، خاصة عند استهداف أنواع ملفات أو أنماط URL محددة.

User-agent: Googlebot

Disallow: /blog/post.php$

دمج التعليقات من أجل الوضوح

استخدم رمز (#) لإضافة تعليقات داخل ملف robots.txt الخاص بك. يمكن أن يساعد ذلك في تنظيم ملفك وتوفير سياق للتوجيهات التي قمت بتعيينها.

# منع Googlebot من زحف صفحات الإدارة

User-agent: Googlebot

Disallow: /admin/

# السماح لـ Googlebot بالزحف إلى صفحات المنتجات

User-agent: Googlebot

Allow: /products/

إدارة النطاقات الفرعية بملفات منفصلة

يجب أن يكون لكل نطاق فرعي ملف robots.txt خاص به. يعد هذا أمرًا بالغ الأهمية لإدارة وصول الزاحف عبر أجزاء مختلفة من موقعك المستضاف على نطاقات فرعية مختلفة.

من خلال اتباع هذه الإرشادات واختبار ملف robots.txt بدقة، يمكنك إدارة كيفية تفاعل محركات البحث مع موقعك بشكل فعال، مما يضمن الزحف إلى المحتوى القيم الخاص بموقعك وفهرسته بشكل مناسب مع إخفاء الصفحات الخاصة أو التى لا تريد أرشفتها.

أفضل ممارسات تحسين محركات البحث لملف Robots.txt

تأكد من أن المحتوى القيم قابل للزحف إليه

تجنب استخدام ملف robots.txt لحظر محتوى أو أقسام موقعك التي تريد فهرستها بواسطة محركات البحث. تذكر أنه لن يتم اتباع الروابط الموجودة على الصفحات المحظورة بواسطة ملف robots.txt، مما قد يمنع اكتشاف المحتوى المهم وفهرسته.

استخدم آليات الحظر المناسبة

بالنسبة للصفحات التي لا ترغب في تجاوز قيمة روابطها أو التي تحتوي على معلومات حساسة، فكر في بدائل لملف robots.txt. نظرًا لأن ملف robots.txt لا يمنع فهرسة الصفحات التي يمكن اكتشافها من خلال وسائل أخرى، استخدم طرقًا مثل الحماية بكلمة مرور أو العلامة الوصفية noindex للتحكم في الوصول والفهرسة.

افهم وكلاء مستخدم محركات البحث

على الرغم من أنه من الممكن تصميم توجيهات لوكلاء مستخدم محددين (على سبيل المثال، Googlebot للبحث العام، وGooglebot-Image للبحث عن الصور)، إلا أن التوجيهات العامة تكون كافية في معظم الأوقات. ومع ذلك، يمكن أن يؤدي تخصيص التوجيهات إلى ضبط كيفية الزحف إلى أنواع مختلفة من المحتوى.

حافظ على تحديث ملف Robots.txt الخاص بموقعك

تقوم محركات البحث بتخزين محتويات ملف robots.txt الخاص بك مؤقتًا ولكن يتم تحديثه بشكل عام. إذا أجريت تغييرات مهمة وتريد التعرف عليها عاجلاً، ففكر في إرسال عنوان URL المحدث لملف robots.txt مباشرةً إلى محركات البحث مثل Google.

من خلال الالتزام بأفضل الممارسات ووضع ملف robots.txt الخاص بك بشكل صحيح، يمكنك توجيه محركات البحث بشكل أكثر فعالية، مما يضمن قيامها بالزحف إلى موقعك وفهرسته بطريقة تتوافق مع أهداف تحسين محركات البحث الخاصة بك.

الملخص

يعد ملف robots.txt أحد الأصول الإستراتيجية في مجموعة أدوات تحسين محركات البحث (SEO) الخاصة بك من خلال توجيه روبوتات محرك البحث عبر بنية موقعك يمكنك التحكم في سرد تواجدك على الإنترنت تذكر أن الهدف ليس مجرد العثور عليه؛ يجب العثور عليه من قبل المستخدمين المناسبين، بالمحتوى المناسب، في الوقت المناسب.وكالتنا مستعدة لمساعدتك على التنقل في هذه المياه التقنية، مما يضمن توافق ملف robots.txt الخاص بك مع إستراتيجية تحسين محركات البحث الشاملة وأهداف العمل الخاصة بك لا تدع إمكانات موقعك تترك دون تحديد. استكشف خدماتنا واتخذ الخطوة الأولى نحو تحسين تواجدك على الويب اليوم.

- تحسين محركات البحث

- فبراير 2024